Erstmals haben Forscher entschlüsselt, wie wir subtile Veränderungen im Tonfall eines Sprechers wahrnehmen. Demnach erfassen wir die Stimmungslage unseres Gegenübers durch ein komplexes Netzwerk in der rechten Hirnhälfte. Wobei unser Bewegungssystems an dieser Wahrnehmung beteiligt ist. Die genaue Kenntnis dieses sogenannten Prosodie-Netzwerkes hilft beim Verständnis zwischenmenschlicher Kommunikation und ihrer Störungen.

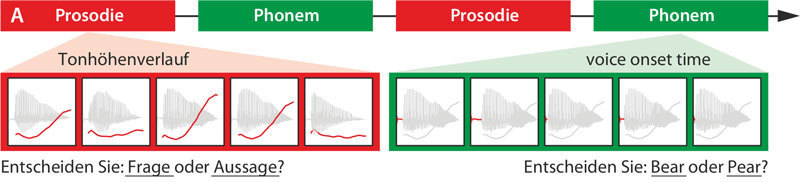

Die Probanden hatten zur Aufgabe, anhand der Tonhöhe zwischen einer Frage und einer Aussage zu unterscheiden. Als Vergleich zu dieser Prosodie-Aufgabe sollten sie darüber hinaus den Anfangsbuchstaben zweier ähnlicher Begriffe heraushören.

© MPI f. Kognitions- und Neuroswissenschaften/ Sammler

Der Tonfall verrät oft mehr über die tatsächlichen Absichten des Sprechers als der reine Inhalt des Gesagten. Er gibt uns Aufschluss über die Bedeutung, die unser Gegenüber seinen eigenen Worten beimisst.

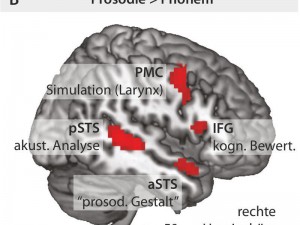

Beim Lösen der Prosodie-Aufgabe sind zwei Gruppen von Gehirngebieten in der rechten Hirnhälfte aktiv (rot).

© MPI f. Kognitions- und Neuroswissenschaften/ Sammler

„Stellen Sie sich doch einfach mal ein leidenschaftlich, ein zögerlich oder ein ironisch gesprochenes „Ja“ in Antwort auf einen Heiratsantrag vor“, schlägt Daniela Sammer vom Max-Planck-Instituts für Kognitions- und Neurowissenschaften in Leipzig vor. „Da haben Sie ein anschauliches Beispiel für die wichtige Funktion des Tonfalls.“ In der Wissenschaft wird dieser Tonfall mit dem Begriff Prosodie beschrieben und umfasst die Gesamtheit aller lautlichen Spracheigenschaften wie Akzent, Intonation oder auch Tempo, Rhythmus und Sprechpausen.

Die Forscher untersuchten die Entschlüsselung der Wortlaute, die vor allem in der linken Hirnhälfte stattfindet. Dabei fanden sie heraus, dass bei der Sprachverarbeitung vor allem die Verbindungen zwischen frontalen und temporalen Hirnregionen entscheidend sind. Doch wie genau erkennen wir den Tonfall unseres Gegenübers?

Um diese Frage zu klären lud das internationale Forscherteam mehrere Testpersonen in ihr Labor ein. Die Englischen Muttersprachler, Männer wie Frauen, bearbeiteten zwei verschiedene Aufgabenkomplexe, während ihre Gehirnfunktionen in einem Tomografen für funktionelle Magnetresonanztomografie (fMRT) gemessen wurden. Bei den Prosodie-Aufgaben sollten die Teilnehmer entscheiden, ob es sich bei den über die Kopfhörer eingespielten Worten um Fragen oder Aussagen handelt. Als Kontrollaufgabe sollten sie darüber hinaus den Anfangsbuchstaben heraushören.

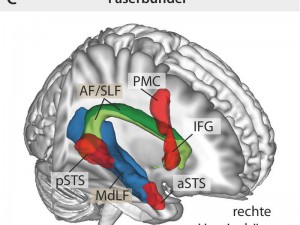

Dorsaler und ventraler Pfad in der rechten Hemisphärefür die Prosodie-Wahrnehmung.

© MPI f. Kognitions- und Neuroswissenschaften/ Sammler

Wie sich zeigte, sind immer dann, wenn wir den Tonfall unseres Gegenübers zu erfassen suchen zwei Gruppen von Hirnarealen in der rechten Hirnhälfte aktiv. Mit Hilfe des posterioren und anterioren superioren temporalen Sulcus (pSTS und aSTS) nehmen wir vermutlich den akustischen Tonhöhenverlauf wahr und schließen daraus, ob unser Gesprächspartner eine Frage gestellt oder eine Aussage gemacht hat. Gleichzeitig sind zwei weitere Hirnareale aktiv: Mit dem inferioren Frontallappen bewerten wir den Tonfall. Doch interessanterweise ist auch unser prämotorischer Kortex auf der Höhe des Larynxareals beim Zuhören aktiviert. Obwohl er normalerweise die Bewegungen des Kehlkopfs steuert, wenn wir selbst etwas äußern. Dann kontrolliert er die Vibration der Stimmbänder und damit die Tonhöhe unserer Stimme.

Offenbar bilden wir die Kehlkopfbewegungen, die unser Gegenüber einsetzt, intern nach. Unser Gehirn übersetzt also quasi das, was wir hören in simulierte Bewegungsbefehle um. Das fördert unser Verständnis von Sprache, indem wir die Bewegungen nachvollziehen, die unser Gegenüber beim Sprechen eingesetzt hat. „Bislang vermutete man diesen Aspekt nur für die nichtprosodische Sprachverarbeitung in der linken Hemisphäre. Die vorliegenden Daten könnten aber für einen ähnlichen Mechanismus in der Wahrnehmung des Tonfalls sprechen“, erklärt Sammler.

Doch bei diesem Informationsaustausch sind, laut den Forschern darüber hinaus auch noch Faserbündel der weißen Substanz beteiligt. Verantwortlich dafür sind dorsale und ventrale Pfade in der rechten Hirnhälfte: Wobei das ventrale Faserbündel dem mittleren longitudinalen Fasciculus und das dorsale Faserbündel dem Verlauf des Fasciculus arcuatus (AF) beziehungsweise des superioren longitudinalen Fasciculus (SLF) folgt. Dieser ist in der linken Hirnhälfte bereits als Verbindungsbahn zwischen den Sprachzentren bekannt.

Das Gehirn nimmt den Tonfall einer Sprache also entlang mehrerer Pfade wahr. Im Unterschied zu anderen Signalpfaden für Sprache liegen sie vor allem in der rechten Hirnhälfte. „Vermutlich lassen sich diese Pfade flexibel kombinieren und erfüllen so unterschiedliche Aufgaben. Dadurch kann das Gehirn feine Untertöne in der Stimme des Gegenübers erkennen“, fasst Sammler zusammen.

Max-Planck-Gesellschaft, 5. November 2015

Originalpublikation:

Daniela Sammler, Marie-Hélène Grosbras, Alfred Anwander, Patricia E. G. Bestelmeyer, and Pascal Belin. Dorsal and ventral pathways for prosody. Current Biology; 5 November, 2015. doi:10.1016/j.cub.2015.10.009