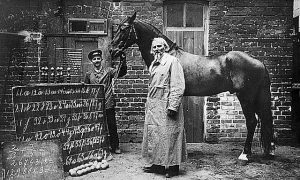

Ähnlich, wie der Kluge Hans um 1900 zwar clever erschien, aber es dennoch nicht war, sind auch viele KI-Systeme nicht so intelligent, wie sie auf den ersten Blick erscheinen. © public domain.

Computeralgorithmen, die auf intelligente Weise Probleme lösen, sogenannte KI-Systeme, sollen dem Menschen das Leben erleichtern. Sie werden etwa als Sprach- und Übersetzungsassistenten, in der Diagnostik, der Bildverarbeitung oder beim autonomen Fahren eingesetzt. Schlagzeilen machen sie, wenn sie menschliche Experten übertreffen, wie etwa Schachprogramme, die inzwischen jeden Menschen mit Leichtigkeit schlagen können. Oder wenn es zu tragischen Unfällen kommt, wie etwa als das KI-System eines Teslas einen weißen Lastwagen nicht als solchen erkannte, sondern ihn für den Himmel hielt und durch ihn hindurch fahren wollte. Da stellt sich die Frage, wie KI-Systeme eigentlich ihre Entscheidungen treffen? Und ob diese Entscheidungen wirklich immer intelligent sind?

KI-Systeme werden nicht nur dort eingesetzt, wo sie dem Menschen langweilige Routineaufgaben abnehmen können, sondern auch in kritischen Bereichen, wie der medizinischen Diagnostik oder dem autonomen Fahren. Bei diesen Systemen ist es ausgesprochen wichtig, dass sie zuverlässig arbeiten. Dazu muss jedoch klar sein, wie diese Systeme zu ihren Entscheidungen gelangen, um sicher zu sein, dass sie nicht durch unsichere Problemlösungsstrategien oder sonstige KI-Schummeleien zu ihren Ergebnissen kommen. Doch genau hier liegt eines der größten Probleme vieler heute eingesetzter KI-Systeme. denn sie werden meist als Black Box System betrachtet und der Weg auf dem sie zu ihren Ergebnissen kommen bleibt nicht selten im Dunkeln.

Ein internationales Forscherteam hat sich genau dieser Frage angenommen. Es hat das gesamte Spektrum der existierenden KI-Systeme mit einer eigens hierfür entwickelten, automatisierten Technologie untersucht. Die sogenannte „Layer-wise Relevance Propagation“ (LRP) macht sichtbar, aufgrund welcher Kriterien ein KI-Systeme zu einer Entscheidung gelangt. Und eine Weiterentwicklung dieses Systems, die „Spectral Relevance Analysis“ (SpRAy), ist dazu in der Lage ein breites Spektrum von Entscheidungsverfahren aufzudecken und zu bewerten. Ihr entgehen auch in großen Datensätzen keine unerwünschten Entscheidungsfindungen.

Mit ihrem neuen Verfahren stellten die Forscher verschiedenste KI-Systeme auf die Probe. Dabei entdeckten sie alles, vom naiven Problemlösungsverhalten, über echte Schummel-Strategien bis hin zu wirklich „intelligenten“ strategischen Lösungsansätzen.

Die Forscher stellten erstaunt fest, dass selbst moderne KI-Systeme nicht immer einen aus menschlicher Sicht sinnvollen Lösungsweg einschlagen, sondern stattdessen eine ‚Clever-Hans-Strategie‘ verfolgen.

Der Clever Hans, oder Kluge Hans, war ein Pferd, das um 1900 viel Aufsehen erregte, da es angeblich rechnen und zählen konnte. Bei genauerer Betrachtung stellte sich jedoch heraus, dass das Tier keineswegs die Mathematik beherrschte, sondern vielmehr die richtige Antwort in etwa 90 Prozent der Fälle durch die genaue Beobachtung der Reaktion des Fragestellers herausfand.

Viele KI-Systeme agieren bei ihren Problemlösungen ähnlich clever. Doch schaut man genauer hin, wie sie zu der Lösung kommen, sehen sie weit weniger intelligent aus. So wendet etwa ein KI-System zur Klassifizierung von Bildern, das vor einigen Jahren mehrere internationale Wettbewerbe gewonnen hat, eine aus menschlicher Sicht naive Lösungsstrategie an: Es klassifiziert Bilder hauptsächlich mit Hilfe des Kontextes. Dabei ordnet es Bilder der Kategorie „Schiff“ zu, wenn viel Wasser im Bild zu sehen ist. Als „Zug“ ordnet es Bilder ein, wenn Schienen vorhanden sind. Bei anderen Bildern bedient es sich gar des Copyright-Schriftzuges, um sie der richtigen Kategorie zuzuordnen. Damit verfehlt es klar sein eigentliches Ziel, nämlich Schiffe oder Züge zu als solche zu erkennen. Denn nur durch die Mogelstrategien gelingt es dem System die meisten Bilder korrekt zu klassifizieren.

Selbst einige der neuesten KI-Algorithmen, die sogenannten tiefen neuronalen Netzwerke erwiesen sich auch nur im Sinne des Klugen Hanses als clever. Stützen sich ihre Klassifikationsentscheidungen doch teils auf Artefakte, die während der Präparation der Bilder entstanden sind, mit dem eigentlichen Bildinhalt jedoch nichts zu tun haben.

So kommen denn die Forscher zu dem alarmierenden Ergebnis, dass der Einsatz solcher KI-Systeme für den praktischen Bereich nicht nur völlig unbrauchbar, sondern in der medizinischen Diagnostik oder in sicherheitskritischen Anwendungen sogar ausgesprochen gefährlich ist. Laut den Forschern ist es durchaus denkbar, dass rund die Hälfte der aktuell eingesetzten KI-Systeme auf solchen ‚Clever Hans‘-Strategien beruht. Daher sei es extrem wichtig systematisch zu überprüfen, wie diese KI-Systeme funktionieren und nur solche Systeme in der Praxis einzusetzen, die auch wirklich sicher sind.

Doch mit der neuen Technik entdeckten die Forscher auch KI-Systeme, die ausgesprochen „intelligente“ Strategien erlernt hatten. Eines dieser Systeme beherrschte die Atari-Spiele „Breakout“ und „Pinball“. Wie die Forscher anerkennend zugaben, hatte dieses System ganz klar das Konzept des Spiels ‚verstanden‘ und einen intelligenten Weg gefunden, zielgerichtet und risikoarm sehr viele Punkte zu sammeln. Dabei kam es auf Lösungen, die ein Mensch bisher nicht gefunden hatte.

Die von den Forschern zur Analyse der KI-Systeme entwickelte, automatisierte Technik ist Open Source und steht allen Wissenschaftlern zur Verfügung.

von Ute Keck, 22. März 2019

Originalpublikation:

Sebastian Lapuschkin, Stephan Wäldchen, Alexander Binder, Grégoire Montavon, Wojciech Samek & Klaus-Robert Müller. Unmasking Clever Hans predictors and assessing what machines really learn. Nature Communications, volume 10, Article number: 1096 (2019). DOI: 10.1038/s41467-019-08987-4