Waldmaus. © Hans Hillewaert. CC BY-SA 3.0

Blätterrascheln, das Knacken eines Astes oder ein besonderer Geruch – für eine Maus sind dies zunächst harmlose Sinneseindrücke. Nicht jedoch, wenn kurz darauf eine Katze aus dem Gebüsch springt – dann waren es Hinweise auf eine lebensbedrohliche Gefahr. Doch wie gelingt es dem Gehirn die wesentlichen Sinneswahrnehmungen zu identifizieren und mit den verzögert auftretenden Ereignissen zu verknüpfen? Diese Frage versuchte ein Forscher zu beantworten, indem er ein Lernschema für ein Computermodell entwickelte. Darin lernen die virtuellen Zellen, aus vielen verschiedenen Reizen die wesentlichen herauszufiltern, indem sie ihre Aktivität mit dem häufigen Hinweisreize synchronisieren. Das funktioniert selbst dann noch, wenn zwischen Hinweisreiz und Ereignis eine zeitliche Lücke besteht. Das von dem Forscher entdeckte Lernschema ist nicht nur für jedes Lebewesen überlebenswichtig, um wichtige Reize aus der Umwelt herauszufiltern. Es hilft auch bei einer Vielzahl technologischer Lernprobleme. Forscher könnten es etwa zur Entwicklung von Programmen zur Spracherkennung einsetzen.

In der Tierwelt künden sich Gefahren oft vorher an: verräterische Geräusche, Bewegungen oder ein Geruch können Hinweise auf einen bevorstehenden Angriff eines Räubers sein. Überlebt etwa eine Maus den Angriff einer Katze, sollte sie aus dem missglückten Angriff lernen und die Hinweise beim nächsten Mal rechtzeitig deuten. Doch prasseln ständig eine Vielzahl sensorischer Eindrücke auf sie ein, von denen die meisten nicht auf eine Gefahr hindeuten. Woher weiß die Maus also, welche Geräusche und Gerüche aus der Umwelt etwa den Angriff einer Katze ankündigen und welche nicht?

Das Mäusegehirn steht dabei vor einem Problem: Denn die entscheidenden Umgebungsreize sind meist zeitlich vom eigentlichen Angriff isoliert. Das Gehirn muss also einen Hinweis und das darauffolgende Ereignis – etwa ein Geräusch und einen Angriff – miteinander verknüpfen, obwohl diese zeitlich auseinander liegen. Bisher war nicht klar, wie das Gehirn die Zeit zwischen einem Hinweisreiz und dem eigentlichen Erlebnis überbrückt. Robert Gütig vom Max-Planck-Institut für experimentelle Medizin hat nun entdeckt, wie das Gehirn dieses Problem lösen könnte. Er hat am Computer ein Netzwerk aus Nervenzellen programmiert, das wie ein biologischer Zellverband auf Erregungen reagiert. Das Netzwerk kann lernen, diejenigen Hinweisreize herauszufiltern, die ein späteres Ereignis vorhersagen.

Das Netzwerk lernt, indem es gezielt Synapsen zwischen den virtuellen Nervenzellen verstärkt oder abschwächt. Das Computermodell basiert auf einer synaptischen Lernregel, nach der einzelne Nervenzellen ihre Aktivität in Abhängigkeit von einem einfachen Lernsignal erhöhen oder absenken. Mit dieser Lernregel setzt Gütig ein neues Lernschema um: „Dieses häufigkeitsbasierte Lernschema beruht auf der Idee, die Verbindungen zwischen Zellen so einzustellen, dass die resultierende neuronale Aktivität über einen Zeitraum gesehen proportional zur Häufigkeit der Hinweisreize wird“, erklärt Gütig. Spiegelt also ein Lernsignal das Auftreten und die Stärke bestimmter Ereignisse im Umfeld der Maus wieder, so lernen die Nervenzellen auf jene Reize zu reagieren, die diese Ereignisse vorhersagen.

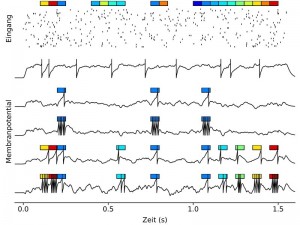

Am Computer hat Robert Gütig Neuronennetzwerke generiert und sie mit unterschiedlichsten Sinnesreizen (farbige Kästen) gefüttert, die sich in der Eingangsaktivität widerspiegeln (Punkte-Raster). Die schwarzen Kurven stellen die Membranpotentialverläufe der Modellnervenzelle dar: vor (oberste Kurve) und nach (zweite bis fünfte Kurven) verschiedenen Lernszenarien. Je nachdem ob und wie viel die einzelnen Sinnesreize zu einem Lernsignal beitragen, lernt die Zelle die zugehörigen Aktivitätsmuster aus der Eingangsaktivität herauszufiltern und mit einer bestimmten Anzahl von Aktionspotentialen zu kodieren.

© MPI für experimentelle Medizin/R. Gütig

Gütigs Netzwerke können aber auch dann lernen, auf Umgebungsreize zu reagieren, wenn keine Lernsignale aus der Umgebung vorhanden sind. Hierzu wird die mittlere neuronale Aktivität innerhalb eines Netzwerkes als Lernsignal interpretiert. Einzelne Nervenzellen lernen nun auf solche Reize zu reagieren, die genauso häufig aufgetreten sind wie die, auf welche die anderen Nervenzellen im Netzwerk reagieren. Dieses „selbst überwachte“ Lernen folgt einem anderen Prinzip, als etwa die Hebbsche Lernregel, die bislang häufig in künstlichen neuronalen Netzen zum Einsatz kam. Solche Hebbschen Netze lernen, indem sie die Synapsen zwischen den Zellen verstärken, die gleichzeitig oder kurz nacheinander aktiv sind. „Beim selbst überwachten Lernen muss die Aktivität der Zellen nicht zeitlich synchronisiert sein. Maßgeblich für die Änderung von Synapsen ist nur die Gesamtaktivität in einem bestimmten Zeitraum“, sagt Gütig. Somit können diese Netzwerke auch Sinnesreize verschiedener sensorischer Modalitäten, z.B. Sehen, Hören und Riechen, verknüpfen, deren neuronale Repräsentationen zeitlich erheblich gegeneinander verschoben sein können.

Gütigs Lernschema erklärt nicht nur biologische Prozesse, sondern könnte auch weitreichenden Verbesserungen innerhalb technologischer Anwendungen, z.B. der künstlichen Spracherkennung, den Weg bereiten. „Es wäre damit möglich, die Anforderungen für das Training computergestützter Spracherkennung erheblich zu vereinfachen. Anstatt aufwendig segmentierter Sprachdatenbanken oder komplexer Segmentierungsalgorithmen genügen für häufigkeitsbasiertes Lernen beispielsweise die Untertitel von Nachrichtensendungen“, so Gütig.

Max-Planck-Gesellschaft, 3. März 2016

Originalpublikation:

Robert Gütig. Spiking neurons can discover predictive features by aggregate-label learning. Science 4 March 2016; DOI: 10.1126/science.aab4113